+48 669 STORIO (786746)

szczególną ochroną

Przełączniki Ethernet

W sieciach komputerowych LAN (Local Area Network) do połączenia wszystkich urządzeń teleinformatycznych z danego obszaru takich jak komputery, telefony IP, serwery czy drukarki, w celu wymiany danych pakietowych pomiędzy nimi niezbędne są przełączniki Ethernet. Urządzenia te zazwyczaj działają w warstwie drugiej modelu OSI, czyli w warstwie łącza danych, natomiast szereg rozwiązań, szczególnie dedykowanych do zastosowań w centrach danych lub jako przełączniki rdzeniowe mają możliwość przełączania w warstwie 3, czyli warstwie sieciowej IP.

W sieciach komputerowych LAN (Local Area Network) do połączenia wszystkich urządzeń teleinformatycznych z danego obszaru takich jak komputery, telefony IP, serwery czy drukarki, w celu wymiany danych pakietowych pomiędzy nimi niezbędne są przełączniki Ethernet. Urządzenia te zazwyczaj działają w warstwie drugiej modelu OSI, czyli w warstwie łącza danych, natomiast szereg rozwiązań, szczególnie dedykowanych do zastosowań w centrach danych lub jako przełączniki rdzeniowe mają możliwość przełączania w warstwie 3, czyli warstwie sieciowej IP.

Switche Ethernet stanowią aktywne elementy połączenia LAN, łączące różne segmenty sieci komputerowej, pozwalające użytkownikom na wspólny dostęp do urządzeń peryferyjnych, programów i baz danych oraz wymianę informacji między różnymi systemami komputerowymi.

Projektując sieć LAN i dobierając odpowiednie przełączniki musimy odpowiedzieć sobie na klika kluczowych pytań:

Dobierając przełączniki do projektowanej sieci należy mieć świadomość, że może ona z czasem rozrastać się, dlatego warto już od początku myśleć o jak największej możliwości skalowalności sieci i urządzeń.

Topologie połączeń

Przełączniki Ethernet mogą być łączone ze sobą na kilka sposobów, tworząc tym samych różne architektury. Topologia sieci określa sposób jej wykonania, czyli połączenia urządzeń teletransmisyjnych za pomocą medium transmisyjnego przy użyciu przełączników. Topologia fizyczna definiuje geometryczną organizację sieci lokalnej przedstawiając w sposób graficzny jej kształt i strukturę.

Rozważając topologie połączeń w sieciach LAN, najczęściej mamy do dyspozycji następujące możliwości:

W topologii gwiazdy połączenia sieci rozchodzą się z centralnego punktu, jakim jest przełącznik, który nie tylko łączy elementy sieci, ale także rozsyła sygnały oraz wykrywa kolizje w sieci.

W topologii gwiazdy połączenia sieci rozchodzą się z centralnego punktu, jakim jest przełącznik, który nie tylko łączy elementy sieci, ale także rozsyła sygnały oraz wykrywa kolizje w sieci.

Zaletami topologii gwiazdy jest duża przepustowość, łatwa rozbudowa oraz szybka lokalizacja uszkodzeń – w przypadku awarii łącza lub komputera pozostała część sieci funkcjonuje bez zastrzeżeń.

Wadą jest duże zapotrzebowanie na kable oraz brak działania jakichkolwiek połączeń w przypadku awarii przełącznika centralnego.

Rys. Topologia gwiazdy

W topologii tej, każdy z przełączników końcowych działa jako urządzenie centralne dla własnej topologii gwiazdy. Pojedyncze gwiazdy połączone są przy użyciu przełączników.

Główną zaletą topologii rozszerzonej gwiazdy jest ograniczenie liczby urządzeń, które muszą być podłączone z centralnym węzłem oraz ograniczenia ruchu lokalnego do pojedynczej gwiazdy a także możliwość zastosowania krótszych kabli połączeniowych do stacji końcowych.

Rys. Topologia rozszerzonej gwiazdy

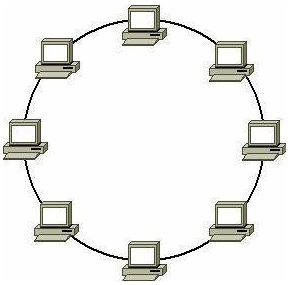

Najmniej popularna technologia, jeśli chodzi o sposób połączeń stacji roboczych. Komputery połączone są ze sobą odcinkami kabla w układzie zamkniętym, tworząc fizyczny krąg. Dane przesyłane są wokół pierścienia w jednym kierunku. Im więcej urządzeń połączonych jest do pierścienia, tym dłuższy jest czas odpowiedzi. Awaria pojedynczego przewodu lub komputera powoduje unieruchomienie całej sieci.

Najmniej popularna technologia, jeśli chodzi o sposób połączeń stacji roboczych. Komputery połączone są ze sobą odcinkami kabla w układzie zamkniętym, tworząc fizyczny krąg. Dane przesyłane są wokół pierścienia w jednym kierunku. Im więcej urządzeń połączonych jest do pierścienia, tym dłuższy jest czas odpowiedzi. Awaria pojedynczego przewodu lub komputera powoduje unieruchomienie całej sieci.

W powyższym opisie topologii pierścienia mowa jest tylko o sposobie połączenia komputerów, bez użycia przełączników. Topologia pierścienia (głównie podwójnego pierścienia) jest także wykorzystywana do połączeń pomiędzy przełącznikami Ethernet.

Rys. Topologia pierścienia

Pętla w połączeniu przełączników

Same przełączniki można łączyć ze sobą używając do tego jakichkolwiek portów dostępowych i odpowiednich kabli krosowych (miedzianych lub światłowodowych w zależności od typu portu) oraz jeśli przełączniki mają możliwość łączenia w stack – poprzez dedykowane porty typu stack.

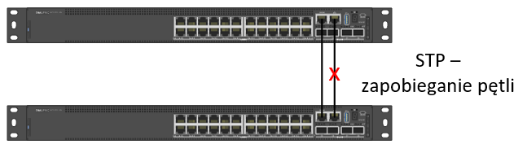

W przypadku, gdy przełączniki łączymy ze sobą przez porty dostępowe z wykorzystaniem jednego kabla krosowego mamy ryzyko utraty komunikacji w sieci, jeśli ten kabel ulegnie awarii. Aby temu zapobiec należy stosować redundantne połączenia kablowe. Jednak, jeśli zestawimy dwa linki pomiędzy dwoma przełącznikami powstanie nam pętla w warstwie drugiej, którą możemy wyeliminować przy użyciu protokołu STP (ang. Spannig Tree Protocol) lub jego nowszych wersji – RSTP czy MSTP.

W przypadku, gdy przełączniki łączymy ze sobą przez porty dostępowe z wykorzystaniem jednego kabla krosowego mamy ryzyko utraty komunikacji w sieci, jeśli ten kabel ulegnie awarii. Aby temu zapobiec należy stosować redundantne połączenia kablowe. Jednak, jeśli zestawimy dwa linki pomiędzy dwoma przełącznikami powstanie nam pętla w warstwie drugiej, którą możemy wyeliminować przy użyciu protokołu STP (ang. Spannig Tree Protocol) lub jego nowszych wersji – RSTP czy MSTP.

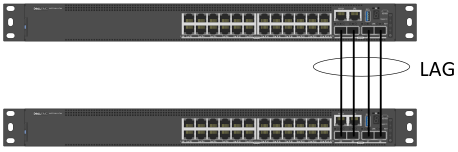

Łączenie przełączników za pomocą zagregowanych portów

W celu zastosowania nadmiarowej ilości połączeń pomiędzy przełącznikami a jednocześnie uniknięciu wyłączenia zapasowych linków przez protokół STP stosujemy zintegrowaną w przełącznikach funkcjonalność LAG (ang. Link Aggregation Port). Standard 802.3ad dopuszcza tworzenie takich zagregowanych łączy w jedną logiczną całość, składającą się z max. 8 połączeń fizycznych pod warunkiem, że łączone porty przełącznika muszą pracować z tą samą szybkością (nie łączymy w obrębie jednego LAG’a ze sobą portów np. 1Gb/s i 10Gb/s) oraz w trybie pełnego duplexu. Możliwe jest natomiast wykorzystanie mieszanych portów przełącznika pod względem rodzaju i typu złącza (np. porty miedziane ze światłowodowymi). Zastosowanie agregacji łączy daje korzyści nie tylko w postaci redundancji połączeń na wypadek awarii pojedynczego łącza, ale także zw iększa przepustowość logicznego, zagregowanego łącza oraz rozkłada obciążenie ruchu na tym łączu.

iększa przepustowość logicznego, zagregowanego łącza oraz rozkłada obciążenie ruchu na tym łączu.

Zagregowane łącze LAG można skonfigurować za pomocą jednej z dwóch metod: poprzez statyczną konfigurację bez użycia protokołów sieciowych, gdzie na przełącznikach wymuszamy utworzenie kanału bez żadnej negocjacji, lub też dynamiczną, z wykorzystaniem protokołu np. LACP (ang. Link Aggregation Control Protocol), który zajmuje się prawidłową konfiguracją tworzonego łącza.

LACP wysyła ramkę LACPDU (Link Aggregation Control Protocol Data Units), która zawiera informacje odnośnie agregacji do wszystkich łączy, które mają włączony protokół LACP. W LACP każdy poszczególny port może zostać skonfigurowany jako aktywny LACP lub pasywny LACP. Port aktywny LACP aktywnie negocjuje tworzenie kanału, natomiast port pasywny biernie czeka na moment w jakim zdalny przełącznik zapoczątkuje negocjację LACP.

Sposób agregacji łączy LACP jest o tyle lepszy od statycznej metody, ponieważ w przypadku LACP awaria jednego fizycznego połączenia zostaje rozpoznana nawet wtedy, gdy przebiega ono przez konwerter mediów, przez co status połączenia pozostaje na porcie przełącznika w stanie „Up”. Dla łączy LACP informacja LACPDUs na tym połączeniu nie jest dostępna i dlatego jest ono usuwane z tego LAG’a. W konfiguracji łącza metodą statyczną, awaria takiego łącza przechodzącego przez konwerter nie byłaby wykryta na przełączniku.

Stakowanie przełączników

Kolejną metodą łączenia ze sobą przełączników jest tworzenie stosu (ang. stack) przy użyciu odpowiednich portów, dedykowanych do tego celu. Taki sposób pozwala łączyć przełączniki magistralą o bardzo dużej przepustowości. Połączenia tego typu są niestety specyficzne dla konkretnego producenta a także nawet w obrębie danej rodziny czy nawet modelu przełączników.

Podstawową zaletą tworzenia stack’a przełączników jest łatwiejsza i szybsza konfiguracja oraz zarządzanie urządzeniami w obrębie stosu a także zwiększenie redundancji połączeń, gdyż urządzenia końcowe bądź przełączniki z innych lokalizacji mogą być podłączone zagregowanym łączem do dwóch różnych członków stosu. Stack oszczędza nam również zasoby adresacji, gdyż wszystkie urządzenia połączone w stos są zarządzane z poziomu interfejsu WWW czy Telnet/SSH przy wykorzystaniu tylko jednego adresu IP.

Podstawową zaletą tworzenia stack’a przełączników jest łatwiejsza i szybsza konfiguracja oraz zarządzanie urządzeniami w obrębie stosu a także zwiększenie redundancji połączeń, gdyż urządzenia końcowe bądź przełączniki z innych lokalizacji mogą być podłączone zagregowanym łączem do dwóch różnych członków stosu. Stack oszczędza nam również zasoby adresacji, gdyż wszystkie urządzenia połączone w stos są zarządzane z poziomu interfejsu WWW czy Telnet/SSH przy wykorzystaniu tylko jednego adresu IP.

Rys. Przełączniki połączone w stack.

Warto tutaj nadmienić, że znaczna część przełączników od różnych producentów, szczególnie z niższej półki cenowej posiada funkcjonalność klastrowania, która nie ma nic wspólnego ze stakowaniem, poza jednym tylko elementem tj. możliwość zarządzania wieloma urządzeniami z poziomu jednego adresu IP.

Architektura połączeń przełączników rdzeniowych

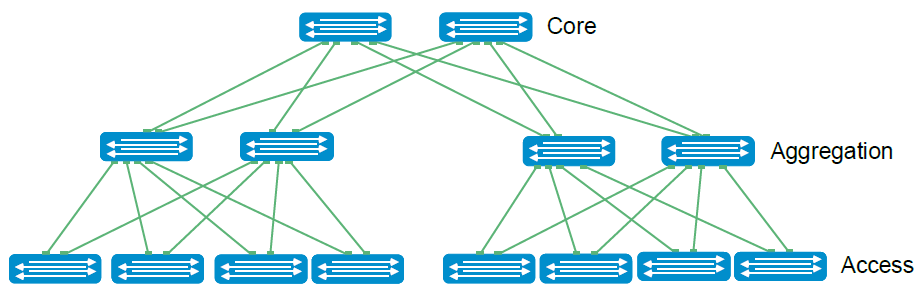

Sieci centrów danych tradycyjnie budowano w trójwarstwowym drzewie hierarchicznym składającym się z warstw dostępu (Access), agregacji (Aggregation) i warstwy rdzeniowej (Core), jak pokazano na rysunku poniżej.

Rys. Tradycyjna architektura połączeń przełączników LAN – model hierarchiczny

Hierarchiczny model sieci, to taki, w którym poszczególne urządzenia są grupowane w warstwy w zależności od swojego przeznaczenia.

W przypadku średnich i mniejszych sieci LAN powstała dosyć popularna architektura zwana połączoną warstwą rdzeniową (ang. Collapsed Core Layer) w której funkcje warstwy rdzeniowej i dystrybucyjnej realizowane są przez jedno urządzenie. Celem takiego zwiniętego rdzenia jest obniżenie kosztów sieci, a jednocześnie utrzymanie wydajności sieci.

.png)

Rys. Architektura połączeń Callapsed Core Layer

W związku z rosnącym ruchem wschód-zachód w nowoczesnym centrum danych (serwer-serwer, serwer-pamięć masowa itp.), w celu zminimalizowania liczby przeskoków między hostami a tym samym zmniejszenia opóźnień, coraz szerzej stosowana jest alternatywa dla tradycyjnego modelu sieci hierarchicznej, znana jako Clos lub Leaf-Spine (tzw. listków na gałęzi).

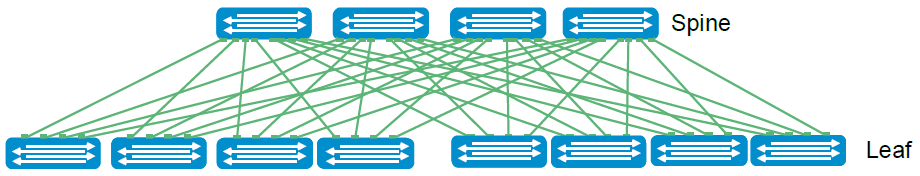

Rys. Architektura Leaf-spine

W architekturze typu leaf-spine warstwa dostępu w której zazwyczaj znajdują się przełączniki dostępowe ToR (ang. Top of Rack) do których są podłączone serwery, pamięci masowe, routery brzegowe i inne elementy sieciowe centrum danych jest nazywana warstwą „liścia – leaf”. Przełączniki „liście” są z kolei podłączone do wyższej warstwy, w której znajdują się wysokowydajne przełączniki szkieletowe określane mianem „gałęzi – spine”.

Przełączniki – „liście” nie są ze sobą połączone bezpośrednio. Każdy przełącznik „liści” łączy się z każdym przełącznikiem „gałęzi”, dzięki czemu wszystkie przełączniki „liści” są oddalone od siebie o nie więcej niż jeden skok, co z kolei minimalizuje opóźnienia i prawdopodobieństwo zatorów w sieci. Przepływy danych w ramach tradycyjnej architektury trójwarstwowej mogą się różnić w zależności od tego, gdzie w sieci znajdują się urządzenia źródłowe i docelowe. W niektórych przypadkach przepływy danych mogą wymagać tylko przejścia o jeden poziom w górę do warstwy dystrybucji, aby dotrzeć do miejsca docelowego. W innych może być konieczne, aby przepływy sięgały aż do rdzenia, a następnie z powrotem w dół stosu.

Architektura leaf-spine jest wysoce skalowalna. Gdy administratorzy dodają szafy do centrum danych, do każdej nowej szafy dodawana jest para przełączników „listków”. Przełączniki „gałęzi” mogą być dodawane w miarę wzrostu wymagań dotyczących przepustowości.

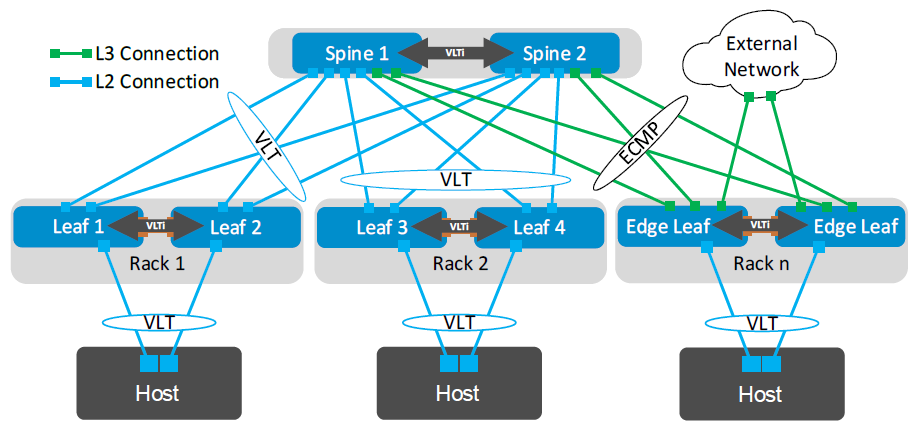

Topologie warstwy 2 i warstwy 3 wykorzystują po dwa przełączniki „liście” na górze każdej szafy skonfigurowane jako para tworząca jedną wirtualną domenę, do której są podłączone urządzenia typu serwer czy macierz dyskowa. Czołowi producenci przełączników Ethernet wykorzystują do tego celu własne protokoły agregacji takie jak VLT (Virtual Link Trunking - Dell), vPC (Virtual Port Channel – Cisco), VC (Virtual Connect – HPE) czy MC-LAG (Multi-Chassis LAG Juniper).

Protokoły te odpowiedzialne są za specyficzną agregację łącz w warstwie drugiej, umożliwiającą aktywność wszystkich połączeń, zapewniając jednocześnie odporność na uszkodzenia. Specyfika tej agregacji polega na tym, że serwer pomimo tego, że łączy się z dwoma fizycznie odrębnymi urządzeniami to logicznie tak, jakby łączył się z jednym wirtualnym przełącznikiem. Ta pojedyncza jednostka logiczna zapewnia wysoką dostępność i wysoką odporność dla wszystkich podłączonych urządzeń dostępu.

Protokoły te odpowiedzialne są za specyficzną agregację łącz w warstwie drugiej, umożliwiającą aktywność wszystkich połączeń, zapewniając jednocześnie odporność na uszkodzenia. Specyfika tej agregacji polega na tym, że serwer pomimo tego, że łączy się z dwoma fizycznie odrębnymi urządzeniami to logicznie tak, jakby łączył się z jednym wirtualnym przełącznikiem. Ta pojedyncza jednostka logiczna zapewnia wysoką dostępność i wysoką odporność dla wszystkich podłączonych urządzeń dostępu.

Rys. Zastosowanie protokołu agregacji VLT

Protokoły agregacji pozwalają zapewnić serwerom redundancję połączeń sieciowych, balansowanie ruchem, eliminację potrzeby stosowania mechanizmów STP (Spanning-Tree Protocol). Alternatywne mechanizmy LAG/LACP zapewniają podobne możliwości, ale w ramach kilku fizycznych połączeń do tego samego przełącznika.

Rys. Architektura połączeń z wykorzystaniem protokołu agregacji VLT w L2 oraz ECMP (ang. Equal cost multi-path routing) do równoważenia obciążenia w sieci warstwy 3

Z obecnym wymogiem obowiązkowej potrzeby wysokiej dostępności w nowoczesnych centrach danych i sieciach korporacyjnych, protokoły agregacji odgrywają kluczową rolę w połączeniach ze wszystkimi węzłami dostępowymi z szybką konwergencją, płynnym przepływem ruchu, wydajnym równoważeniem obciążenia i mechanizmem wolnym od pętli.

Połączenia przełączników w dwóch Data Center

Do łączenia przełączników pomiędzy dwoma Data Center wykorzystujemy dostępne protokoły (zarówno te ustandaryzowane jak i opracowane przez konkretnego producenta) w warstwie 2 lub 3. Najważniejsza cecha wspólna to stosowanie redundancji połączeń przełączników, dzięki czemu mamy gwarancję wysokiej dostępności.

Na przykładzie przełączników firmy Dell Technologies, połączenie Data Center Interconnect (DCI) między domenami VLT jest obsługiwane w systemie operacyjnym OS10 z funkcją VRRP w domenach VLT (technologia eVLT). VRRP można skonfigurować dla podwójnych domen VLT, aby utworzyć topologię eVLT, jak pokazano na rysunku poniżej. Ten sam identyfikator grupy VRRP umożliwia wspólny wirtualny adres IP w obu domenach VLT. W związku z tym każdą migrację maszyny wirtualnej z DC1 do DC2 można zainicjować bez żadnej zależności, zachowując jednocześnie adres IP maszyny wirtualnej i adres IP bramy.

Rys. Architektura połączeń dwóch DC z wykorzystaniem VRRP

Grupa VRRP dla skonfigurowanych sieci VLAN powinna mieć ten sam identyfikator grupy VRRP w obu domenach VLT. W tej implementacji tylko jeden węzeł jest wybierany jako główny VRRP, podczas gdy pozostałe trzy węzły działają jako rezerwowe dla grupy VRRP. Przykładowo wirtualny adres IP 192.168.1.254 jest zachowywany w obu DC1 i DC2. W przypadku migracji maszyny wirtualnej z bramą domyślną 192.168.1.254 z DC1 do DC2, maszyna wirtualna może nadal zachować swój adres IP i kontynuować przekazywanie i odbieranie ruchu bez żadnych zmian.

Urządzenia nadrzędne z domen VLT mogą mieć routing statyczny lub dowolne inne protokoły routingu dynamicznego w celu obsługi ruchu północ-południe. Host jest ciągle dostępny, niezależnie od tego czy ruch do hosta maszyny wirtualnej trafia przez DC1 czy DC2, co zapewnia wysoką dostępność aplikacji i usług.

Firma STORIO chętnie doradzi w doborze odpowiednich przełączników Ethernet dla każdej warstwy połączeniowej, od dostępowej po data center a także zaproponuje odpowiednią architekturę połączeń pomiędzy urządzeniami.

Zapraszamy do kontaktu.

STORIO